DeepSeek представила передовые ИИ-модели V3.2 и V3.2-Speciale

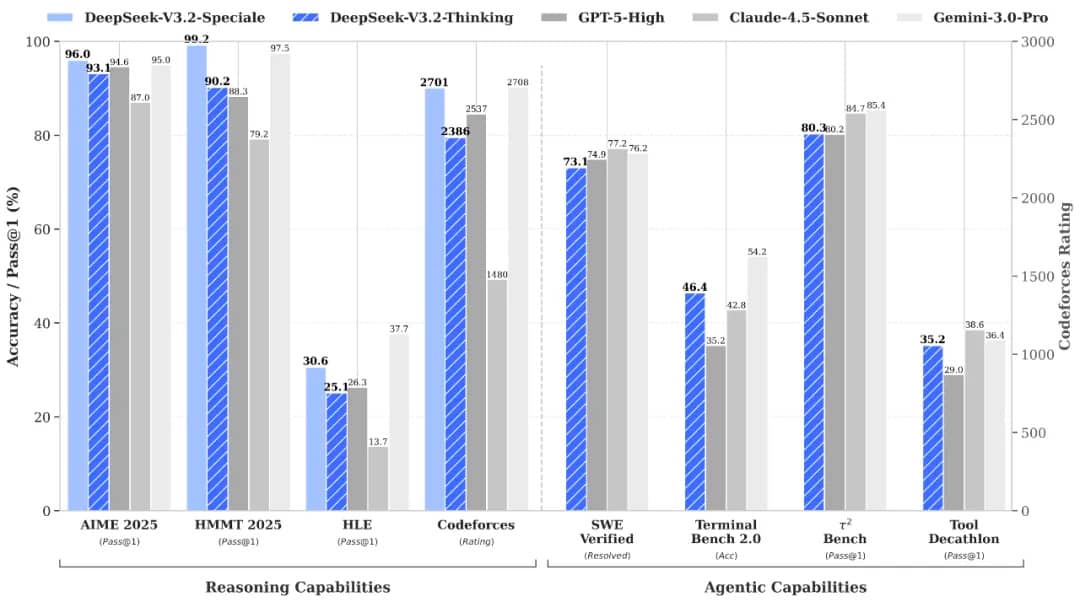

По данным DeepSeek, новые открытые модели V3.2 и V3.2-Speciale способны конкурировать, а местами и превосходить самые мощные современные ИИ-системы, включая GPT-5 от OpenAI и Gemini 3 Pro от Google.

Вместо того чтобы гнаться за масштабом любой ценой, DeepSeek продолжает придерживаться стратегии, основанной на эффективности. Пока американские лаборатории полагаются на огромные кластеры новейших чипов, DeepSeek утверждает, что ее отточенный подход к обучению позволяет добиться сопоставимого уровня интеллекта на более доступном оборудовании. По словам компании, даже стандартная модель изначально поддерживает инструментальное и структурированное рассуждение — пользователю не нужно переходить в отдельный «режим reasoning».

Главное же внимание привлекает версия V3.2-Speciale. DeepSeek заявляет, что эта модель превзошла GPT-5 во внутренних тестах и показывает результаты уровня Gemini 3 Pro в задачах, требующих глубоких рассуждений. В подтверждение компания приводит свои выступления на Международной математической олимпиаде и Международной олимпиаде по информатике 2025 года, подчеркнув, что окончательные решения доступны для ознакомления.

По словам DeepSeek, такой скачок в качестве стал возможен благодаря двум ключевым инновациям: собственному механизму разреженного внимания, оптимизированному для работы с длинным контекстом, и расширенному конвейеру обучения с подкреплением, включающему более 85 000 сложных многошаговых задач, созданных при помощи внутренней системы «agentic task synthesis».

Тем, кто хочет опробовать новинки, модель V3.2 уже доступна на сайте DeepSeek, в мобильных приложениях и через API. Более экспериментальная V3.2-Speciale работает только через временную API-точку, которая будет отключена после 15 декабря 2025 года. Сейчас она функционирует как движок, рассчитанный исключительно на рассуждение, без поддержки вызова инструментов.

Источник: gizmochina

AI

-1.png)