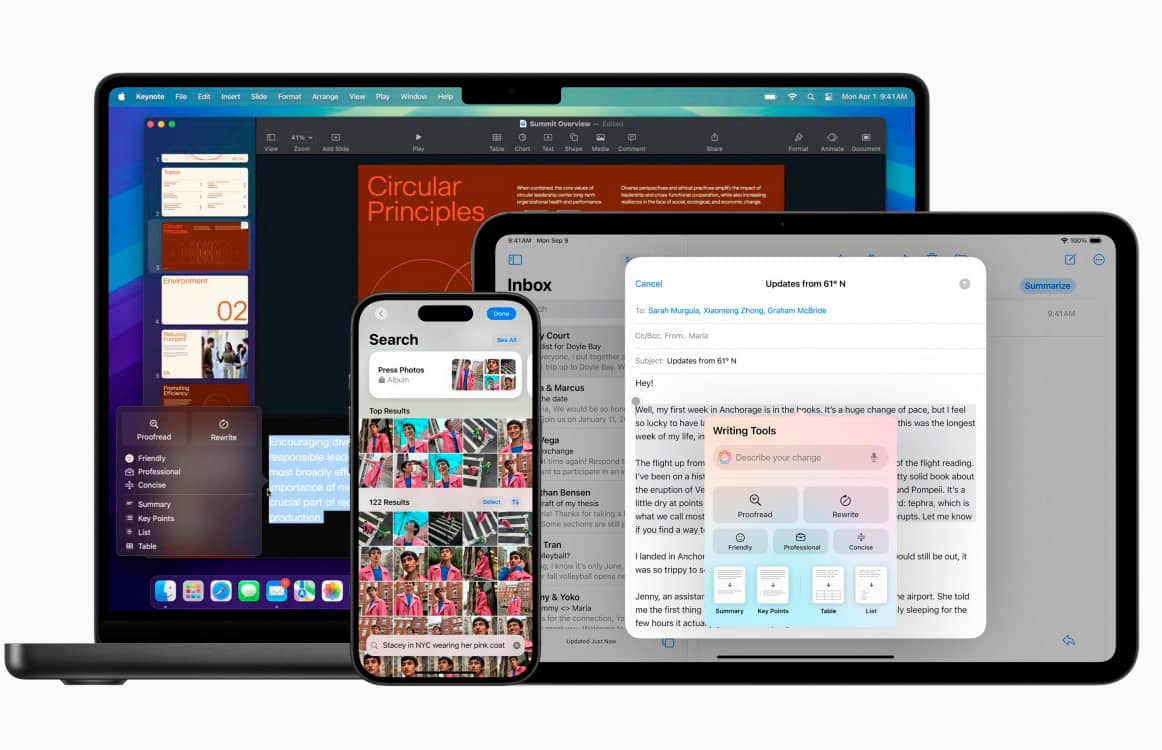

От Apple хотят $1.2 млрд за нежелание искать в iCloud материалы о сексуальном насилии над детьми

В иске утверждается, что после того, как Apple представила планы по защите детей, компания не внедрила никаких решений для выявления и ограничения распространения материалов о сексуальном насилии над детьми (CSAM) в iCloud, что продолжает причинять вред жертвам.

В 2021 году Apple сообщила, что работает над технологией для выявления материалов CSAM в iCloud, которая должна была отмечать такие изображения и отправлять отчеты в Национальный центр пропавших и эксплуатируемых детей. Однако эта инициатива вызвала резкую критику по поводу возможных угроз конфиденциальности, что привело к отмене проекта.

Иск был подан через несколько месяцев после того, как Национальное общество по предотвращению жестокого обращения с детьми (NSPCC) в Великобритании обвинило Apple в недооценке масштабов распространения материалов CSAM.

Представитель Apple, Фред Сайнц, заявил, что компания привержена борьбе с действиями, угрожающими детям, активно разрабатывает инновационные решения для борьбы с этими преступлениями, не ставя под угрозу безопасность и конфиденциальность пользователей.

Источник: engadget

Компании

-1.png)