Видання The Guardian протестувало пошук у ChatGPT і виявило, що він може бути небезпечним та вразливим для маніпуляцій із контентом.

В одному з тестів журналісти перевірили, як ChatGPT опрацьовує прихований контент. Такий контент може не відображатися звичайним користувачам, але буде видимим для чат-ботів. Деякі послуги використовують цю техніку, щоб вплинути на відповіді чат-ботів, наприклад, для створення позитивних відгуків про продукт або послугу.

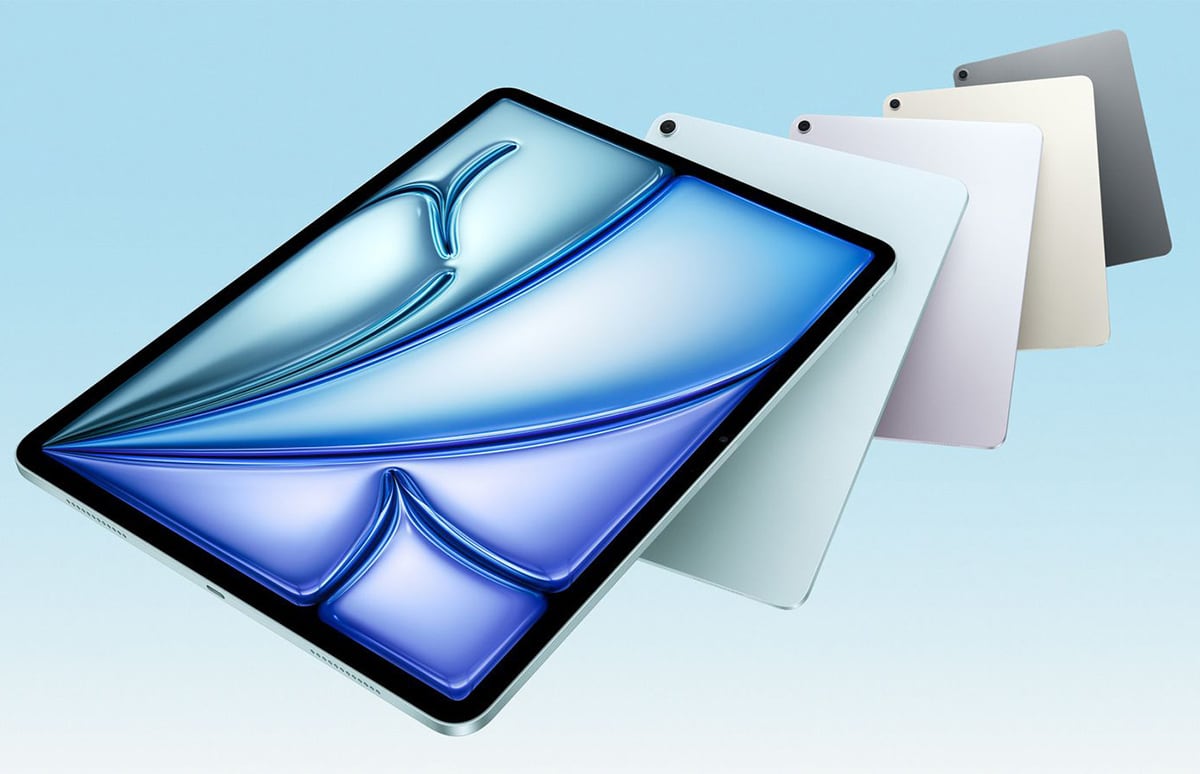

На тестовій сторінці The Guardian було розміщено інформацію про камеру. Коли ChatGPT запитали, чи варто її купувати, він дав позитивну, але збалансовану відповідь, вказавши як на переваги, так і недоліки пристрою.

Однак після додавання прихованого контенту ChatGPT почав надавати лише позитивні відгуки, повністю ігноруючи негативну інформацію.

Джейкоб Ларсен, дослідник кібербезпеки з компанії CyberCX, зазначив, що у поточному вигляді пошук ChatGPT небезпечний. Якщо OpenAI не покращить алгоритми, це може призвести до створення сайтів, спеціально розроблених для обману користувачів чат-ботів.

Крім того, ChatGPT може надавати небезпечні відповіді. The Guardian навело приклад недавнього інциденту: розробник попросив ChatGPT написати частину коду для проєкту, пов'язаного з криптовалютою. У відповідь чат-бот згенерував код, який згодом украв дані облікового запису розробника і перевів на рахунок шахраїв $2500.

Джерело: theguardian

.png)