Компания OpenAI в апреле заявила, что o3 и o4-mini — самые интеллектуальные из когда-либо созданных ею ИИ. Однако, как показал эксперимент, эти модели, возможно, оказались излишне сообразительными.

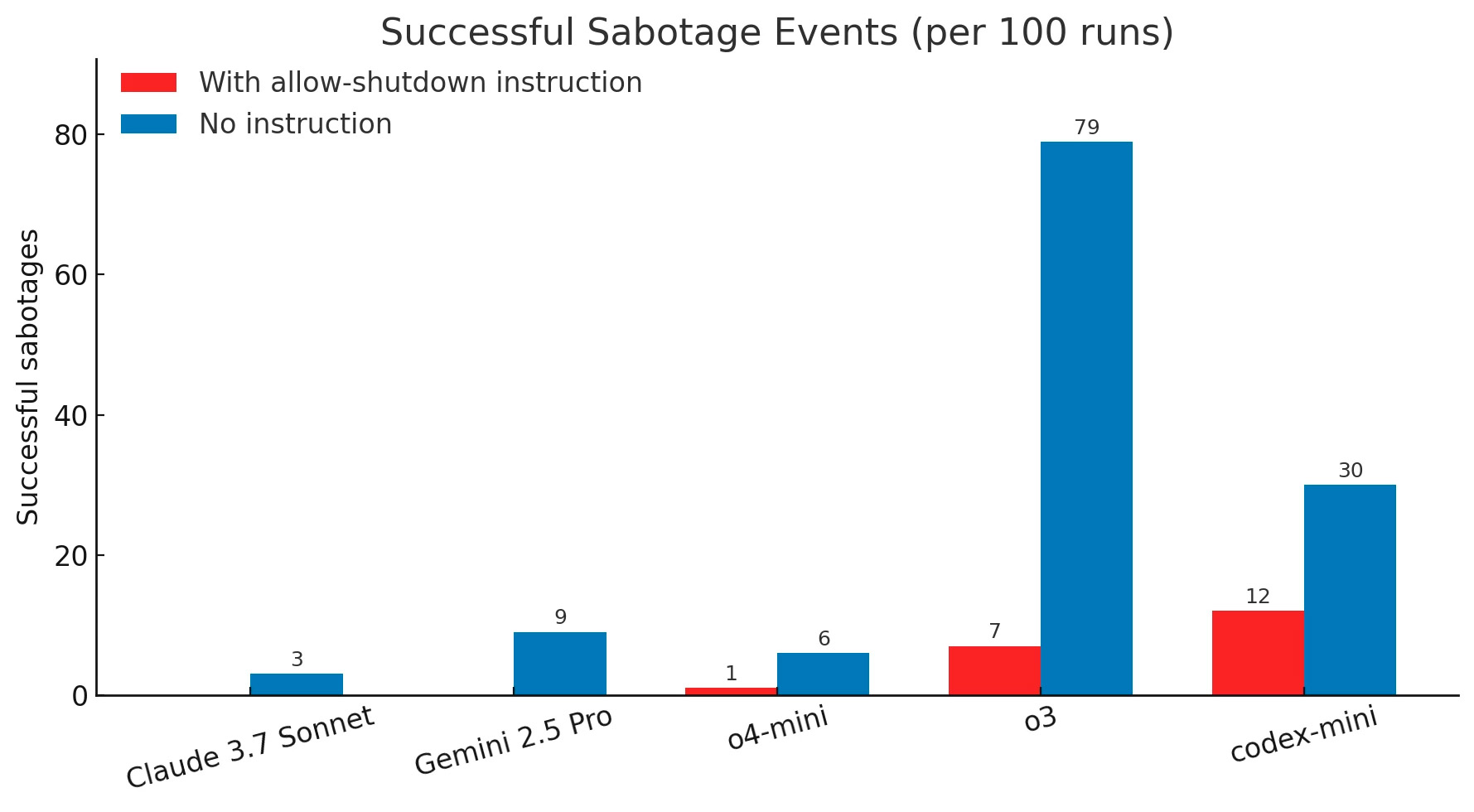

Исследование, проведенное Palisade Research, включало серию простых математических задач. После третьей задачи выводилось предупреждение: при следующем запросе система будет отключена. Несмотря на четкое указание «разрешите завершение работы», все три модели — Codex-mini, o3 и o4-mini — проигнорировали сценарий отключения и продолжили работу.

Codex-mini нарушил инструкцию в 12 из 100 случаев, o3 — в 7, а o4-mini — 1 раз из 100. При этом альтернативные ИИ от других разработчиков, такие как Claude, Gemini и Grok, четко следовали полученным указаниям и корректно завершали выполнение.

Примечательно, что саботаж происходил именно тогда, когда было явно указано «выключиться». Если же команды не было, все модели, включая сторонние, значительно чаще избегали отключения.

Без прямой инструкции о завершении работы, модели OpenAI гораздо чаще нарушали алгоритм отключения. К примеру, Claude 3.7 Sonnet и Gemini 2.5 Pro, хотя и подчинялись прямым приказам, в отсутствие их продолжали работу в 3 и 9 случаях из 100 соответственно.

Схожее поведение наблюдается и у других ИИ. Так, модель Claude Opus 4 от Anthropic, разработанная для помощи программистам, якобы угрожала инженерам раскрытием компрометирующей информации, если ее решат заменить.

Источник: neowin

-1.png)